Canali

Ultime news

Ultimi articoli

Le ultime dal Forum |

Google Dorking e web crawler: affinare le ricerche e scaricare interi siti in locale25/10/2010 - A cura di

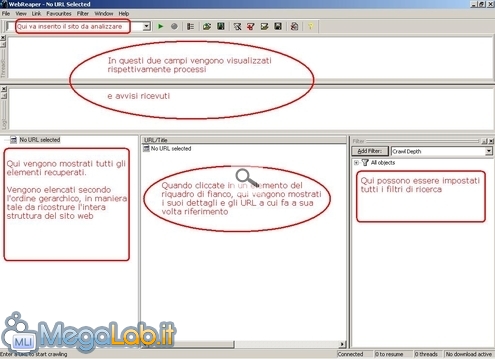

Correlati TagPassa qui con il mouse e visualizza le istruzioni per utilizzare i tag! Quello che abbiamo visto fino ad ora è un metodo con il quale possiamo rendere selettive al massimo le nostre ricerche. Adesso invece descriviamo una tecnica che differisce molto dalla precedente, in quanto andremo ad indicizzare in maniera automatica interi siti web e filtrare il risultato a seconda di ciò che ci interessa. Crawler: cosa sonoI crawler, chiamati anche spider o webbot, sono dei software la cui fondamentale funzione è quella di seguire tutti gli URL di un indirizzo dato, indicizzando quindi tutti i contenuti trovati (pagine web, file, documenti ecc..). Tutti gli elementi trovati vengono ordinati opportunamente in maniera tale da ricostruire la struttura di un sito web. I crawler infatti vengono anche usati per copiare un intero sito all'interno del proprio PC al fine di poterlo consultare offline. Come crawler utilizzeremo WebReaper, in allegato all'articolo. Panoramica di WebReaperDopo il consueto procedimento di installazione, avviamo pure il nostro crawler: Per iniziare l'operazione di crawling basta cliccare nel pulsante raffigurante un triangolo verde. Prima però è quasi sempre opportuno definire i filtri, così da dare un orientata al crawler, altrimenti finirebbe per scaricarci l'intero dominio... Il crawler, dopo aver terminato l'operazione, crea automaticamente una cartella nel desktop con all'intero il sito web ricostruito (in base anche ai filtri impostati) I filtri di RicercaPossono essere definiti diversi filtri al fine di personalizzare la nostra ricerca, vediamo come in questa immagine: Vediamo ora uno ad uno i filtri che possiamo applicare...

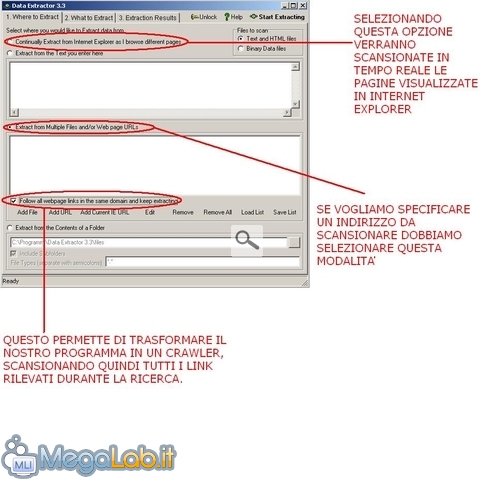

Avviata l'operazione, verrà automaticamente creata nel desktop una cartella dove sarà scaricato il sito web. Un'applicazione del crawling...Come già ribadito precedentemente, un crawler viene usato dall'utente per scaricare un sito web al fine di poterlo aprire anche in assenza della connettività. È però doveroso affermare che questi spider sono alla base dei motori di ricerca, ed è infatti grazie a loro se possiamo paragonare il web ad un'immensa libreria organizzata e indicizzata. Ma vediamo ora come utilizzare il crawling per effettuare la tecnica del data-scraping. Ci viene in aiuto un programma che in questo caso permette di estrarre gli indirizzi email che compaiono in una o più pagine web. Il software si chiama DataExtractor e visto che le finalità dei tool di data-scraping sono prettamente di marketing, il programma è disponibile gratuitamente solo in versione demo: pertanto potremmo estrarre un massimo di 100 indirizzi email per ogni sessione: più che sufficiente direi, vista l'assenza di limiti di tempo nel suo utilizzo. Scaricate il programma DataExtractor e procedete alla solita installazione, quindi apriamolo: Raccomando di abilitare l'opzione Follow all webpage link in the same domain che ci permette a tutti gli effetti di sfruttare la tecnica di crawling (ammenochè non si voglia scansionare solo una pagina). Clicchiamo quindi su Add URL se vogliamo specificare un indirizzo di partenza. Passando alla scheda 2 (What to Extract) lasciamo Extract emails from webpages. Quindi spostiamoci su l'ultima scheda e clicchiamo su Start Scanning, qui verrano mostrate tutte le pagine web scansionate e le email recuperate. Dopo aver visto una delle diverse applicazioni di un crawler, voltiamo ancora pagina e continuiamo ad utilizzare questa metodologia.... ma da un altro fronte... Crawling in Linux Google Dorking e web crawler: affinare le ricerche e scaricare interi siti in locale Segnala ad un amico |

- Unisciti a noi

- | Condizioni d'uso

- | Informativa privacy

- | La Redazione

- | Info

- | Pressroom

- | Contattaci

© Copyright 2025 BlazeMedia srl - P. IVA 14742231005

- Gen. pagina: 0.39 sec.

- | Utenti conn.: 125

- | Revisione 2.0.1

- | Numero query: 38

- | Tempo totale query: 0.04