Canali

Ultime news

Ultimi articoli

Le ultime dal Forum |

Google Dorking e web crawler: affinare le ricerche e scaricare interi siti in locale25/10/2010 - A cura di

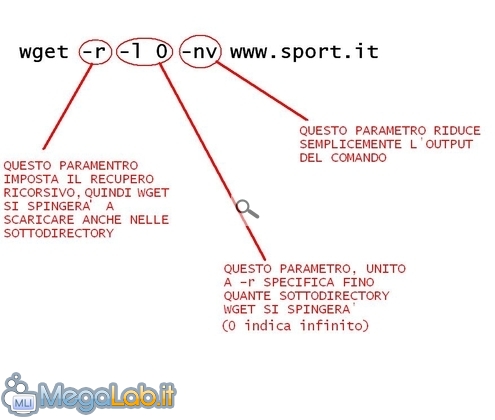

Correlati TagPassa qui con il mouse e visualizza le istruzioni per utilizzare i tag! Wget e il recupero ricorsivoWget è un famoso tool a riga di comando per lo scaricamento dei file dal web. Una della funzionalità di questo programma è la capacità di comportarsi come un crawler seguendo i collegamenti di una pagina web e, anche in questo caso, aggiustare la ricerca mediante appositi filtri. Lanciamo dunque il nostro terminale in Linux e vediamo di capire questo comando: wget -r -l 0 -nv www.sport.it. Lanciando questo comando Wget inizierà il download di tutti gli elementi presenti nel sito specificato, verranno a mano a mano mostrati nell'output e l'intero sito verrà ricostruito in locale (nella home directory). Quindi con questo semplice comando abbiamo fatto ciò che prima avevamo compiuto con WebReaper. Un paio di considerazioni:

Filtrare tipi di fileOvviamente è possibile impostare Wget per scaricare solo determinati tipi di file, basta aggiungere l'opzione -A seguita dall'estensione del file. Ad esempio wget -A jpg -r -l 0 -nv www.sport.it ricostruirà in locale l'albero delle directory del sito specificato, ma scaricherà solamente i file jpg. Anche in questo caso, nell'output del comando verranno visualizzati tutti gli URL scansionati, ma saranno effettivamente scaricati solamente quelli specificati nell'eventuale filtro impostato. Raggruppamento dei file scaricatiA volte può tornare utile posizionare tutti i file scaricati in un unica cartella, senza che vengano ordinati nelle rispettive sottocartelle magari sparse nelle varie radici. Questo è attuabile aggiungendo l'opzione -nd Quindi lanciando il comando wget -nd -r -l 0 -nv www.sport.it verranno scaricati gli elementi del sito www.sport.it e messi tutti nella cartella di destinazione (che possiamo anche specificare con -P). Interfaccia grafica per WgetConcludiamo segnalando anche l'esistenza di una comoda interfaccia grafica per questo programma, ma ovviamente non dispone di tutta la flessibilità della riga di comando, il suo nome è gwget ed è scaricabile nei repository. Decisamente più interessante è invece la versione per Windows, che unisce l'immediatezza dell'interfaccia grafica con la flessibilità della sua versione a riga di comando, ma che non sarà oggetto di questa trattazione. Crawling Pagine

Segnala ad un amico |

- Unisciti a noi

- | Condizioni d'uso

- | Informativa privacy

- | La Redazione

- | Info

- | Pressroom

- | Contattaci

© Copyright 2025 BlazeMedia srl - P. IVA 14742231005

- Gen. pagina: 2.39 sec.

- | Utenti conn.: 86

- | Revisione 2.0.1

- | Numero query: 43

- | Tempo totale query: 0.16