Canali

Ultime news

Ultimi articoli

Le ultime dal Forum |

Correlati

TagPassa qui con il mouse e visualizza le istruzioni per utilizzare i tag!

Il pezzo che stai leggendo è stato pubblicato oltre un anno fa.

La trattazione seguente è piuttosto datata. Sebbene questo non implichi automaticamente che quanto descritto abbia perso di validità, non è da escludere che la situazione si sia evoluta nel frattempo. Raccomandiamo quantomeno di proseguire la lettura contestualizzando il tutto nel periodo in cui è stato proposto. La trattazione seguente è piuttosto datata. Sebbene questo non implichi automaticamente che quanto descritto abbia perso di validità, non è da escludere che la situazione si sia evoluta nel frattempo. Raccomandiamo quantomeno di proseguire la lettura contestualizzando il tutto nel periodo in cui è stato proposto.

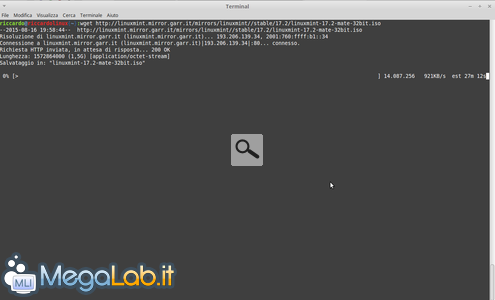

A volte potrebbe essere necessario scaricare completamente un sito web per poterlo consultare anche mentre non si è collegati ad Internet. Per fare questo Linux mette a disposizione uno strumento semplice ed efficace: WGET WGET è un comando da avviare dalla shell di Linux che ci consente di scaricare file di cui conosciamo il percorso esatto online o addirittura interi siti Web. Wget ha il vantaggio di consumare poche risorse e non rallenta il sistema. Per scaricare un file basta aprire un terminale e scrivere ad esempio "wget http://linuxmint.mirror.garr.it/mirrors/linuxmint//stable/17.2/linuxmint-17.2-mate-32bit.iso" E verrà scaricata. la ISO di Linux mint nella cartella utente Lo stesso concetto è applicabile al download di un sito web, la sintassi del comando è la seguente: Wget -k -r -p -D sitoweb.it --restrict-file-names=UNIX http://www.sitoweb.it Dove -k permette alla fine del processo di download di convertire tutti i link ai file locali in modo da permettere la navigazione offline -r permette il download di tipo ricorsivo, così facendo scaricherà sicuramente l'intero sito web e se dovessero esserci pagine o contenuti non disponibili continuerà a richiamrli fino a che non effettua il download -p permette di scaricare anche ciò di cui si ha bisogno per visualizzare correttamente il sito web (fogli di stile, immagini, Javascript...) -D serve a non ritrovarvi il computer pieno di pagine web inutili, scarica solo i link interni al dominio indicato --restrict-file-name permette di modificare i nomi dei file così da non andare n contrasto con il sistema operativo che si sta usando, i possibili parametri sono UNIX o Windows a seconda se il sito deve essere visualizzato su Windows o Linux L'ultimo parametro è l'URL del sito web da scaricare. P.s. questa procedura scarica solo le pagine del sito Web con i contenuti, non ha niente a che vedere con la sicurezza ed i database. Segnala ad un amico |

- Unisciti a noi

- | Condizioni d'uso

- | Informativa privacy

- | La Redazione

- | Info

- | Pressroom

- | Contattaci

© Copyright 2025 BlazeMedia srl - P. IVA 14742231005

- Gen. pagina: 0.3 sec.

- | Utenti conn.: 131

- | Revisione 2.0.1

- | Numero query: 44

- | Tempo totale query: 0.1