Google Dorking e web crawler: affinare le ricerche e scaricare interi siti in locale

Quando ci affidiamo ad Internet per la ricerca di un'informazione, la prassi è quella di dirigerci presso il nostro motore di ricerca di fiducia e iniziare a scrivere nell'apposito campo le parole che pensiamo siano congrue con l'informazione voluta.

In risposta, il motore di ricerca ci elencherà, secondo un ordine ben preciso, tutte le pagine web indicizzate che contengono le chiavi di ricerca immesse.

Normalmente siamo abituati immettere come chiave di ricerca una o più semplici parole. Tuttavia il motore di ricerca Google permette di inserire delle particolari chiavi dette operatori e metacaratteri con le quali possiamo estendere la ricerca oltre il semplice testo, scandagliando file, directory e raffinare i risultati.

Google Dorking

Che si chiami Google Hacking, Google Dorking o semplicemente Dorking non ha importanza in quanto ci si riferisce alla medesima tecnica, ossia quella di utilizzare gli operatori messi a disposizione da Google per effettuare una ricerca più approfondita.

C'è una lista di metacaratteri e operatori che ora vi elencheremo con spiegazione ed esempi. Per utilizzarli basta scriverli normalmente nel campo di ricerca uniti alla nostra chiave di ricerca.

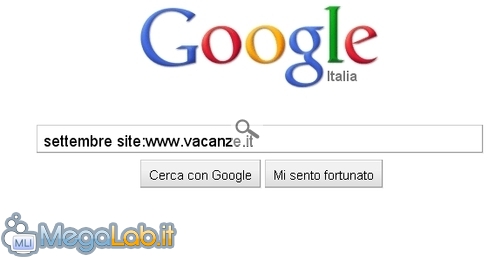

Cominciamo con un esempio di una normale chiave di ricerca:

Lanciando questa ricerca Google ci elencherà quindi tutte le pagine web che contengono la parola settembre.

Proviamo ora ad inserire un operatore...

Questa ricerca ci elencherà tutte le pagine web all'interno del sito www.vacanze.it che contengono la parola settembre.

Abbiamo quindi usato l'operatore site, che, come abbiamo intuito, ci permette di restringere la ricerca su di un sito.

Descrizione degli operatori principali di Google

Di seguito l'elenco degli operatori messi a disposizione da Google:

- intitle: elenca le pagine web il cui titolo contiene la parola chiave immessa - ESEMPIO: intitle:riassunto. Trova tutte le pagine il cui titolo contiene la parola riassunto

- inurl: elenca le pagine web che hanno nel proprio URL la parola chiave immessa - ESEMPIO: inurl:pub. Trova tutte le pagine che contengono la parola pub nel proprio URL

- site: Restringe la ricerca alle pagine web del sito specificato - ESEMPIO: site:www.megalab.it. Trova tutte le pagine web del sito www.MegaLab.it

- link: Elenca le pagine web che contengono un link al sito specificato nella parola chiave - ESEMPIO: link:www.megalab.it. Elenca tutte le pagine web che contengono un link verso www.MegaLab.it

- filetype: Elenca i file presenti nel web avente l'estensione specificata - ESEMPIO: filetype:mp3. Elenca tutti i file MP3 presenti nel web

Metacaratteri di Google

Oltre ai precedenti operatori, ce ne sono diversi altri che possono essere affiancati ai primi:

- AND: Questo è un operatore booleano e va inserito tra due parole chiave. Il risultato sarà quindi tutte le pagine web che contengono entrambe le chiavi di ricerca scritte - ESEMPIO: sport AND nuoto. Elenca tutte le pagine web che contengono le parole sport e nuoto

- OR: Ecco un altro operatore booleano, come per il precedente va inserito tra due chiavi di ricerca e ne restituirà tutte le pagine che contengono o una parola o l'altra - ESEMPIO: sport OR nuoto. Elenca tutte le pagine web che contengono o la parola sport o la parola nuoto.

- -: È il segno meno, svolge la funzione di esclusione. Va inserito attaccato all'operatore o parola da escludere dalla ricerca - ESEMPIO: gatto -site:www.animali.it . Elenca tutte le pagine web che contengono la parola gatto, tranne quelle nel sito www.animali.it

- *: È l'asterisco e sostituisce una parola intera - ESEMPIO: pedale * automobile. Elenca tutte le pagine web che contengono pedale, una parola qualsiasi e automobile

- ..: Sono due puntini e svolgono la funzione di un range numerico - ESEMPIO: negozi aperti il 6..14 luglio. Effettua una normale ricerca testuale ma dove al posto dei due puntini vengono cercati numeri compresi tra 6 e 14.

Come utilizzarli

Questi operatori possono essere usati così come li avete visti oppure in combinazione tra di loro, in modo da affinare ulteriormente la ricerca; ecco alcuni esempi:

- ristorante -intitle:pesce site:www.paginegialle.it. Trova le pagine web all'interno di www.paginegialle.it che contengano la parola ristorante ma che nel loro titolo non hanno la parola pesce

- intitle:gallina AND gallo. Trova le pagine web il cui titolo contenga la parola gallina e la parola gallo.

È inoltre possibile sfruttare questi dork per effettuare delle ricerche non convenzionali, come l'elencazione di particolari tipi di piattaforme di hosting, dei file di configurazione che qualche webmaster ha sbadatamente lasciato liberi nel proprio server o la pagina di qualche webcam pubblica...

Insomma abbinando i dork alla giusta chiave di ricerca possiamo ottenere con semplicità informazioni che altrimenti risulterebbero quasi irraggiungibili.

Se volete approfondire l'utilizzo dei Google Dork per effettuare delle ricerche più underground vi rimando a questo sito, dove potete trovare il Google Hacking Database, con descrizione ed esempi.

Per chi possiede Mozilla Firefox segnalo la presenza di un Add-on che permette di usufruire dei dork in maniera semplice e veloce.

Chiudendo la parte relativa al Google Dorking, voltiamo pagina e vediamo un'altra tecnica attuabile nel web...

Quello che abbiamo visto fino ad ora è un metodo con il quale possiamo rendere selettive al massimo le nostre ricerche. Adesso invece descriviamo una tecnica che differisce molto dalla precedente, in quanto andremo ad indicizzare in maniera automatica interi siti web e filtrare il risultato a seconda di ciò che ci interessa.

Crawler: cosa sono

I crawler, chiamati anche spider o webbot, sono dei software la cui fondamentale funzione è quella di seguire tutti gli URL di un indirizzo dato, indicizzando quindi tutti i contenuti trovati (pagine web, file, documenti ecc..).

Tutti gli elementi trovati vengono ordinati opportunamente in maniera tale da ricostruire la struttura di un sito web. I crawler infatti vengono anche usati per copiare un intero sito all'interno del proprio PC al fine di poterlo consultare offline.

Come crawler utilizzeremo WebReaper, in allegato all'articolo.

Panoramica di WebReaper

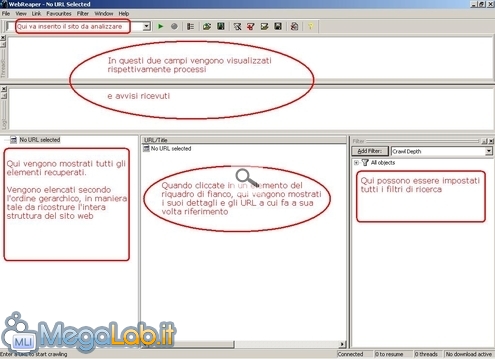

Dopo il consueto procedimento di installazione, avviamo pure il nostro crawler:

Per iniziare l'operazione di crawling basta cliccare nel pulsante raffigurante un triangolo verde. Prima però è quasi sempre opportuno definire i filtri, così da dare un orientata al crawler, altrimenti finirebbe per scaricarci l'intero dominio...

Il crawler, dopo aver terminato l'operazione, crea automaticamente una cartella nel desktop con all'intero il sito web ricostruito (in base anche ai filtri impostati)

I filtri di Ricerca

Possono essere definiti diversi filtri al fine di personalizzare la nostra ricerca, vediamo come in questa immagine:

Vediamo ora uno ad uno i filtri che possiamo applicare...

- Crawl Depth: Aggiungendo questo filtro possiamo scegliere la profondità della ricerca in termini di pagine. Più semplicemente, questo filtro ci permette di stabilire fino a quante pagine lontane dalla partenza il crawler raggiungerà.

- Download Time: È una sorta di Timeout. Il crawler annulla il download dell'oggetto che impiega più di x secondi ad essere scaricato.

- File Extension: Con questo filtro possiamo limitare il download dei soli tipi di file specificati, o viceversa, escluderli. (I file verranno comunque indicizzati e pertanto compariranno tra i risultati nel quadrante).Questo filtro è simile all'operatore filetype che avevamo precedentemente visto nei Google Dork.

- HTML / Binary: Questo filtro ci permette di scegliere se scaricare solamente le pagine HTML o anche i file binari. (I file verranno comunque indicizzati e pertanto compariranno tra i risultati nel quadrante)

- Keywords: Questo filtro permette di scaricare solamente le pagine che contengono una determinata parola. (I file verranno comunque indicizzati e pertanto compariranno tra i risultati nel quadrante)

- Server from Root: Aggiungendo questo filtro possiamo scegliere fino a quanti server dalla partenza il crawler può allontanarsi.

Avviata l'operazione, verrà automaticamente creata nel desktop una cartella dove sarà scaricato il sito web.

Un'applicazione del crawling...

Come già ribadito precedentemente, un crawler viene usato dall'utente per scaricare un sito web al fine di poterlo aprire anche in assenza della connettività. È però doveroso affermare che questi spider sono alla base dei motori di ricerca, ed è infatti grazie a loro se possiamo paragonare il web ad un'immensa libreria organizzata e indicizzata.

Ma vediamo ora come utilizzare il crawling per effettuare la tecnica del data-scraping.

Ci viene in aiuto un programma che in questo caso permette di estrarre gli indirizzi email che compaiono in una o più pagine web.

Il software si chiama DataExtractor e visto che le finalità dei tool di data-scraping sono prettamente di marketing, il programma è disponibile gratuitamente solo in versione demo: pertanto potremmo estrarre un massimo di 100 indirizzi email per ogni sessione: più che sufficiente direi, vista l'assenza di limiti di tempo nel suo utilizzo.

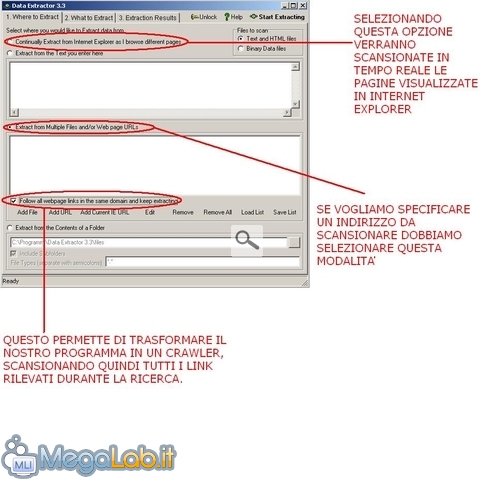

Scaricate il programma DataExtractor e procedete alla solita installazione, quindi apriamolo:

Raccomando di abilitare l'opzione Follow all webpage link in the same domain che ci permette a tutti gli effetti di sfruttare la tecnica di crawling (ammenochè non si voglia scansionare solo una pagina).

Clicchiamo quindi su Add URL se vogliamo specificare un indirizzo di partenza.

Passando alla scheda 2 (What to Extract) lasciamo Extract emails from webpages.

Quindi spostiamoci su l'ultima scheda e clicchiamo su Start Scanning, qui verrano mostrate tutte le pagine web scansionate e le email recuperate.

Dopo aver visto una delle diverse applicazioni di un crawler, voltiamo ancora pagina e continuiamo ad utilizzare questa metodologia.... ma da un altro fronte...

Wget e il recupero ricorsivo

Wget è un famoso tool a riga di comando per lo scaricamento dei file dal web. Una della funzionalità di questo programma è la capacità di comportarsi come un crawler seguendo i collegamenti di una pagina web e, anche in questo caso, aggiustare la ricerca mediante appositi filtri.

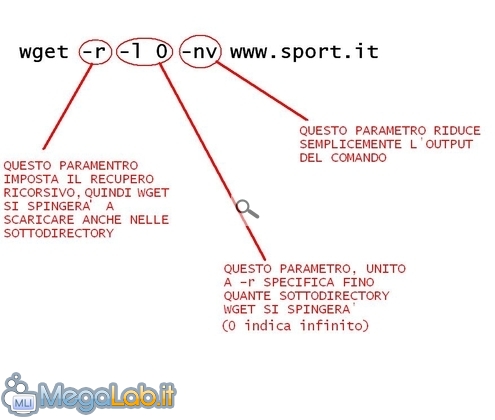

Lanciamo dunque il nostro terminale in Linux e vediamo di capire questo comando: wget -r -l 0 -nv www.sport.it.

Lanciando questo comando Wget inizierà il download di tutti gli elementi presenti nel sito specificato, verranno a mano a mano mostrati nell'output e l'intero sito verrà ricostruito in locale (nella home directory). Quindi con questo semplice comando abbiamo fatto ciò che prima avevamo compiuto con WebReaper.

Un paio di considerazioni:

- Se l'intenzione è proprio quella di scaricare l'intero sito, in caso di problemi è possibile aggiungere l'opzione -k che converte i link nelle pagine per la visione in locale.

- Nel caso invece una pagina faccia riferimento a dei contenuti fuori dal dominio, anche mediante il recupero ricorsivo quest'ultimi non verranno scaricati, pertanto è necessario aggiungere l'opzione -p seguita dalla pagina web. Questo comando in pratica si occupa di scaricare tutti i contenuti necessari affinché la pagina web possa essere visualizzata nella sua interezza. Risulta quindi utile qualora in una pagina vi sia un contenuto multimediale hostato in un altro server (che non verrebbe quindi recuperato).

Filtrare tipi di file

Ovviamente è possibile impostare Wget per scaricare solo determinati tipi di file, basta aggiungere l'opzione -A seguita dall'estensione del file.

Ad esempio wget -A jpg -r -l 0 -nv www.sport.it ricostruirà in locale l'albero delle directory del sito specificato, ma scaricherà solamente i file jpg.

Anche in questo caso, nell'output del comando verranno visualizzati tutti gli URL scansionati, ma saranno effettivamente scaricati solamente quelli specificati nell'eventuale filtro impostato.

Raggruppamento dei file scaricati

A volte può tornare utile posizionare tutti i file scaricati in un unica cartella, senza che vengano ordinati nelle rispettive sottocartelle magari sparse nelle varie radici. Questo è attuabile aggiungendo l'opzione -nd

Quindi lanciando il comando wget -nd -r -l 0 -nv www.sport.it verranno scaricati gli elementi del sito www.sport.it e messi tutti nella cartella di destinazione (che possiamo anche specificare con -P).

Interfaccia grafica per Wget

Concludiamo segnalando anche l'esistenza di una comoda interfaccia grafica per questo programma, ma ovviamente non dispone di tutta la flessibilità della riga di comando, il suo nome è gwget ed è scaricabile nei repository.

Decisamente più interessante è invece la versione per Windows, che unisce l'immediatezza dell'interfaccia grafica con la flessibilità della sua versione a riga di comando, ma che non sarà oggetto di questa trattazione.

MegaLab.it rispetta la tua privacy. Per esercitare i tuoi diritti scrivi a: privacy@megalab.it .

Copyright 2008 MegaLab.it - Tutti i diritti sono riservati